IT-Nachrichten

Diese Entwicklungen prägen die BI-Zukunft

- Details

Die Weiterentwicklung von BI wird nicht nur durch technische Neuerungen bestimmt, sondern vor allem durch die Art, wie Unternehmen Daten nutzen wollen.

Die Weiterentwicklung von BI wird nicht nur durch technische Neuerungen bestimmt, sondern vor allem durch die Art, wie Unternehmen Daten nutzen wollen.

Obwohl Business Intelligence (BI) alles andere als ein neues Thema ist, zählt es noch immer zu den wichtigsten für viele Unternehmen. Die Zukunft prägen nicht nur technische Neuerungen, sondern vor allem die Art, wie und wofür Firmen künftig BI nutzen. Unternehmen steuern einen immer größeren Teil ihrer Geschäftsprozesse durch IT-Lösungen. Damit steigt automatisch auch der Bedarf an Funktionen, mit denen sich Daten aus diesen Systemen visualisieren und auswerten lassen.

Längst ist es nicht mehr nur die Finanzabteilung, die Berichte und Analysen nutzt. Vielmehr fordern Fachbereiche entsprechende Lösungen, um Einblick in ihre Geschäftsprozesse - etwa Vertrieb, Einkauf, Logistik und Produktion - zu erhalten. Abteilungen wollen fundierte Entscheidungen treffen, den Geschäftsverlauf planen und dabei Risiken abschätzen können.

Bewegung in den BI-Markt selbst kam durch neue, leicht zu bedienende Systeme von Spezialisten. Diese Analysewerkzeuge haben das Interesse vieler Fachanwender geweckt und darüber hinaus die großen BI-Hersteller veranlasst, ihre eigenen Produkte weiterzuentwickeln.

Breites Aufgabenspektrum

Business Intelligence steht dabei als Oberbegriff für eine Reihe von Funktionsbereichen: darunter Reporting, Datenanalyse, Prognosen, Planung und Konsolidierung. Ferner zählen dazu Lösungen für die Einhaltung von gesetzlichen Vorschriften und Auflagen (Compliance). Während Reporting noch den größten Teil des Marktes ausmacht, legen die, gemessen am Gesamtmarkt, noch kleineren Bereiche derzeit stark zu.

Ein weiterer Trend sind BI-Anwendungen. Hierbei werden BI-Funktionen für einen - meist auf eine Branche zugeschnittenen - Aufgabenbereich vorkonfiguriert. Reporting, Planungsverfahren sowie Prognosesysteme werden hierbei kombiniert. Beispiele sind etwa Lösungen für die Vorhersage von Service- und Wartungsfällen, Betrugserkennung im Bereich der sozialen Sicherungssysteme und das Risiko-Management im Bankensektor.

Natürlich fangen Unternehmen nicht jetzt erst an, sich über Business Intelligence Gedanken zu machen. Vielerorts existieren bereits Werkzeuge für die Auswertung von Daten, jedoch ist festzustellen, dass Anwender - völlig zu Recht - hohe Ansprüche an BI stellen, was die leichte Bedienbarkeit und Anpassbarkeit anbetrifft. Aus diesem Grund investieren Firmen in neue Lösungen oder bauen bestehende Installationen aus beziehungsweise um.

Darunter findet sich eine steigende Anzahl von Firmen, die beginnen, unterschiedliche BI-Lösungen zu konsolidieren. Mitunter betrifft dies auch Konzerne oder Firmengruppen, die ihren Wildwuchs an BI-Systemen durch eine international einheitliche Umgebung ersetzen wollen.

Schrittweise Erneuerung

In den nächsten Jahren wird es eine ganze Reihe von Ersatz- sowie Zusatzinvestitionen im BI-Segment geben. Dabei werden nicht immer die kompletten Architekturen in Frage gestellt, jedoch werden sich Firmen künftig nach Alternativen für spezifische Bereiche umsehen, etwa zur Visualisierung von Daten, zur Unterstützung mobiler Endgeräte oder zur Social-Media-Analyse. Breiten Raum wird hier ferner der Bereich Leistungsverbesserung einnehmen, der weiter unten zur Sprache kommt.

Einfache Bedienung, schnelle Verfügbarkeit von Ergebnissen sowie die Möglichkeit, die Produktivität der Mitarbeiter zu steigern, zählen zu den wichtigsten Erwartungen der Firmen an Lösungen für Business Intelligence. Das mag selbstverständlich klingen, doch wie PAC-Studien ergeben haben, sehen bei Weitem nicht alle Unternehmen diese Anforderungen durch die von ihnen genutzten Systeme als erfüllt an. Aus diesem Grund zählt der Bedarf an Funktionen, die für eine höhere Produktivität sowohl von Entscheidungsträgern als auch Sachbearbeitern sorgen, zu den wichtigsten Treibern im Markt.

In diesem Zusammenhang setzt sich der Trend fort, dass Anwender selbst in der Lage sein wollen, mit Hilfe des BI-Systems Fragen zu beantworten, ohne erst die interne IT beauftragen zu müssen. Das ist nicht auf die Gestaltung von Berichten beschränkt, sondern umfasst auch die Integration von Datenquellen. Der IT fällt dabei die Aufgabe zu, die Infrastruktur bereitzustellen, die diese Selbständigkeit der Fachbereiche ermöglicht.

BI-Systeme werden künftig wesentlich öfter abteilungs- beziehungsweise bereichsübergreifend genutzt, was entsprechende Formen der Zusammenarbeit unterschiedlicher Anwendergruppen voraussetzt (Collaboration). Experten aus verschiedenen Fachrichtungen müssen sowohl an der Gestaltung von Analysen als auch an der Auswertung beteiligt werden.

In puncto Produktivitätssteigerung wird auch die mobile Verfügbarkeit von BI eine Rolle spielen. BI-Systeme werden künftig in der Lage sein müssen, unterschiedliche Geräte (Desktops, Notebooks sowie mobile Endgeräte mit unterschiedlichen Formfaktoren) möglichst effizient zu unterstützen.

Schnellere Reaktionen

Firmen müssen ständig alle relevanten Einflussfaktoren im Blick haben und darauf reagieren können. Dazu zählen beispielsweise die Marktentwicklung (Preisentwicklung, Konjunktur sowie Konkurrenzsituation) sowie das Kaufverhalten der Kunden. Das war schon immer so. Neu ist jedoch, dass Unternehmen sich gezwungen sehen, in immer kürzerer Zeit adäquat reagieren zu können. Auch hier spielt Business Analytics eine herausragende Rolle. Entscheidungsträger benötigen Auswertungen zeitnah und möglichst detailliert, da sie in der Lage sein müssen, Veränderungen schnell zu erkennen und rasch darauf zu reagieren. Reaktionsfähigkeit bedeutet hier einerseits, sich gegen negative Einflüsse zu wappnen (neue Wettbewerber, Rohstoffpreise etc.), aber andererseits auch, Initiative zu ergreifen, wenn sich eine Geschäftschance bietet (Ansprache einer neuen Kundenzielgruppe oder Expansion in neue Märkte).

Damit das gelingt, sind auch organisatorische Fähigkeiten erforderlich, um anhand der Analyseergebnisse sogleich entsprechende Maßnahmen einzuleiten. Bei aller Faszination für die Technik der Software sollten dies weder Anwender noch BI-Anbieter ausblenden.

Event Processing

Viele IT-Initiativen von Unternehmen zielen darauf ab, zügiger reagieren zu können. Daten müssen sich schnell aus unterschiedlichen Quellen zusammenführen und zur Entscheidungsunterstützung aufbereiten lassen. Auch das kann eigentlich als Grundanforderung an BI angesehen werden. Doch angesichts der Vielschichtigkeit und Häufigkeit der geforderten Auswertungen durch Fachbereiche, verbunden mit dem enormen Zuwachs an zu verarbeitenden Daten sowie Datenquellen, wird eine hohe Reaktionsfähigkeit zur Herausforderung.

Schnelle Reaktionen werden auch durch Systeme für Complex Event Processing (CEP) ermöglicht, die ebenfalls vermehrt in BI-Plattformen Einzug halten. Diese Verfahren unterstützen Unternehmen dabei, auf Ereignisse zu reagieren, die aus der kontinuierlichen Analyse von Daten resultieren. Zu den Datenquellen zählen hier beispielsweise Börsenticker, Ereignisse aus Geschäftsapplikationen, aber zunehmend auch elektronische Sensoren sowie Telekommunikationsnetze.

Integriertes BI

Ein weiterer Trend, der in Zukunft noch mehr an Bedeutung gewinnen wird, ist die Integration von BI in Anwendungssoftware. Schon heute verfügen viele Geschäftsanwendungen über integrierte BI-Funktionen, deren Umfang aber noch zunehmen wird. Zum Teil werden Anbieter von Applikationen die eigenen BI-Module durch Komponenten von BI-Spezialisten ergänzen oder sogar zu deren Gunsten aufgeben.

Integration bezieht sich jedoch nicht nur auf die Benutzerschnittstelle. Vielmehr geht es auch darum, BI-Systeme mit Geschäftsapplikationen so zu verbinden, dass Firmen aus Analyseergebnissen mögliche Prozessanpassungen ableiten und realisieren können. Hierbei wird die Kombination von BI und Business-Process-Management von großer Bedeutung sein.

Leistungsverbesserung

Ein weiteres zentrales Thema im BI-Umfeld ist mit dem Begriff "Big Data" verbunden. Damit ist nicht nur die rasant steigende Anzahl an Daten gemeint, sondern auch die zunehmende Menge an Datenquellen und -formaten, die verarbeitet beziehungsweise analysiert werden müssen. Vermehrt wollen Unternehmen beispielsweise die große Menge an Inhalten aus Social-Media-Netzen wie Facebook auswerten.

Das bedeutet durchaus nicht, dass Investitionen in bestehende BI-Lösungen überflüssig werden. Vielmehr ist abzusehen, dass durch Big Data der Bedarf an zusätzlichen Auswertungs-, Datenbank- sowie Datenintegrationssystemen zunehmen wird.

Da bestehende BI-Lösungen nicht immer gut für die neuen Aufgaben gerüstet sind, besteht ein großer Bedarf an Leistungsverbesserung. Hier kommen neue Datenbanktechniken für die Datenanalyse sowie In-Memory-Computing ins Spiel. Eine Reihe von Herstellern entwickelt dazu spezielle Software, zum Teil kombiniert mit Hardwarebausteinen. Jeder große IT-An-bieter bearbeitet dieses Thema mittlerweile, sei es durch neue Entwicklungen, Übernahmen oder Partnerschaften.

Einerseits dienen die In-Memory-Systeme als Beschleuniger für bestehende Data Warehouses, andererseits können Firmen bestimmte Workloads komplett auf diese schnellen Systeme auslagern.

Doch nicht nur die Software wird sich in den nächsten Jahren weiterentwickeln, sondern auch das Angebot an IT-Dienstleistungen (Beratung, Integration und Betrieb) für BI. Das BI-Umfeld zählt auch im Segment Projektdienstleistungen zu den Wachstumstreibern.

Prozessberatung gefragt

Bei den Dienstleistungen (Beratung, Systemintegration) wird die Bedeutung von rein technischen Services eher abnehmen, während beispielsweise die IT- und Prozessberatung rund um BI wichtiger werden wird. Ursache dafür ist die stärkere Verzahnung von BI mit Geschäftsprozessen. Solche Dienstleistungen werden für die Softwareanbieter immer mehr zum differenzierenden Faktor.

In den Bereich Dienstleistungen fällt auch der Aspekt "BI aus der Cloud". Hierbei gilt es wie immer bei diesem Thema, Private und Public Cloud zu unterscheiden. Unternehmen, die Private Clouds errichten, werden ihre BI-Systeme ebenfalls darauf betreiben. In Zukunft wird es aber auch einen Markt für BI aus der Public Cloud geben - sowohl Angebot als auch Nachfrage sind zumindest auf dem deutschsprachigen Markt noch überschaubar. Einerseits wird es sich dabei um integrierte BI-Funktionen von SaaS-Lösungen handeln - dazu zählen CRM-SaaS-Systeme. Andererseits werden BI-Anbieter ihre heute noch als Software verfügbaren Lösungen als Cloud-Service anbieten - entweder selbst über eigene Cloud-Data-Center oder über die Cloud-Infrastrukturen von Partnern. Quelle

Frank Niemann

Big-Data-System oder Data Warehouse?

- Details

Rasant wachsende Datenmengen stellen Unternehmen vor neue Herausforderungen und vor allem vor die Frage: Mit welchem System soll die Datenflut gebändigt werden, um einen größtmöglichen Nutzen herauszuholen?

Rasant wachsende Datenmengen stellen Unternehmen vor neue Herausforderungen und vor allem vor die Frage: Mit welchem System soll die Datenflut gebändigt werden, um einen größtmöglichen Nutzen herauszuholen?

Das Trendthema Big Data sorgt derzeit für Begeisterung, aber auch Verwirrung in manchen Anwenderunternehmen: Angesichts packender Berichte über den Einsatz von Big Data bei erfolgreichen Web-2.0-Akteuren wie Amazon.com und Facebook fragen sie sich: Könnten Big-Data-Verfahren nicht auch nutzbringend in der eigenen Organisation verwendet werden? Unter welchen Umständen ist Big Data zu empfehlen? Und für IT-Entscheider lautet die wesentliche Frage: Kann der Nutzen, den Big Data verspricht, auch mit den bereits vorhandenen, einfacheren Mitteln - sprich einem Data Warehouse - erreicht werden?

Data Warehouse

Data-Warehouse-Systeme enthalten Datenbestände, die periodisch aus Transaktionssystemen entnommen, gefiltert und zu Analysezwecken aggregiert werden. Häufig wird ein Data Warehouse in täglichen Ladevorgängen mit Daten befüllt und hat deshalb eine Latenzzeit, was die Aktualität der Daten betrifft, von einem Tag. Die Pivottabelle ist das am meisten benutzte Analyseinstrument im Umfeld von Data Warehousing. Oft stellen Pivottabellen die Ausprägungen quantitativer Größen gemäß qualitativen Kriterien tabellarisch dar. Ein typisches Beispiel sind nach Produkten und Regionen gegliederte Umsätze. Auch der Einsatz anderer statistischer Verfahren - Stichwort Data Mining - ist im Data Warehouse möglich, jedoch nicht so verbreitet wie die Analyse mit Pivottabellen. Der Hauptgrund dafür sind die aggregierten, grobkörnigen Daten, die statistisch lohnende Eigenschaften ausblenden und darauf basierende statistische Analysen so ausschließen. Ein weiterer wichtiger Grund ist die Komplexität der Data-Mining-Verfahren.

Big Data und Big Data Analytics

Die Definitionskriterien von Big Data sind je nach Quelle unterschiedlich. In einem sind sich jedoch alle einig: Bei Big Data handelt es sich um Datenmengen, die mit herkömmlichen Mitteln nicht mehr effizient zu verwalten sind. Dazu gehören nicht aggregierte, in Echtzeit ermittelte Daten, die beispielsweise aus Transaktionssystemen, wissenschaftlichen Versuchen, Simulationen oder Sensoren stammen.

Neben Big Data hat sich der Begriff Big Data Analytics etabliert. Letztere umfassen analytische Verfahren, um Erkenntnisse aus großen Datenmengen zu gewinnen. Das Besondere: Methoden aus Statistik, Marketing und Informationstechnik werden bei Big Data Analytics nutzbringend verschmolzen. Wann ist ein Data Warehouse einem Big-Data-System ebenbürtig oder sogar vorzuziehen? Die nachfolgenden Einsatzszenarien geben eine Antwort.

-

Big-Data-Systeme setzen Mustererkennung ein, um Trends und Muster rechtzeitig zu identifizieren sowie bislang unbekannte oder vermutete Beziehungen zwischen einzelnen Parametern zu entdecken. Systeme, mit denen sich Zeitreihen auf Anomalien prüfen lassen, werden beispielsweise dazu verwendet, potenziellen Kreditkartenbetrug in Echtzeit aufzudecken. Damit lassen sich tausende Kreditkartentransaktionen pro Sekunde sofort kontrollieren. Im Gegensatz zu herkömmlichen Data Warehouses sind Real Time Data Warehouses aber anspruchsvoll und stellen daher in der Praxis eher die Ausnahme dar. Durch die Datenaggregation werden die Daten grobkörniger, so dass mit Data Warehouses nur eingeschränkte statistische Analysen möglich sind. Die Folge: Die Erkennung von Trends, Mustern und Zusammenhängen in Data Warehouses bleibt im Resultat eher grob und auf längere Latenzzeiten beschränkt.

-

Die Feinkörnigkeit und die kurzen Latenzzeiten der Datenbestände von Big Data bilden wichtige Voraussetzungen zur Segmentierung in Echtzeit, wie zum Beispiel bei Online-Einkäufen. Verbreitet ist die Bildung von Kundensegmenten, etwa um individuelle Angebote für komplexe Produkte zu erstellen - zum Beispiel Lebensversicherungen. Data Warehouses bieten ebenfalls die Möglichkeit zur Bildung von Segmenten. Diese sind allerdings grobkörniger und haben eine längere Latenzzeit als die Segmente von Big-Data-Systemen.

-

Monitoring stellt aufgrund der enormen Datenmengen eine der Hauptanwendungen von Big Data dar. Mit Real Time Monitoring können beispielsweise Probleme mit komplexen Anlagen und Transportmitteln frühzeitig erkannt und Gegenmaßnahmen ergriffen werden. Darüber hinaus lassen sich durch die Kombination von Monitoring und Mustererkennung Frühwarnsysteme realisieren. Aufgrund ihrer Grobkörnigkeit und langen Latenzzeiten sind Data Warehouses jedoch nur bedingt dafür geeignet - Echtzeitsysteme sind hier die bessere Wahl.

-

Empfehlungssysteme haben das Ziel, Größen wie den Umsatz gezielt zu beeinflussen. Dazu werden aus bestehenden Daten in Echtzeit Empfehlungen abgeleitet. Unternehmen wie Amazon.com und Facebook empfehlen ihren Nutzern gezielt weitere Bücher beziehungsweise Freunde. Sofern die Datenbestände nicht allzu groß sind, um vertretbare Antwortzeiten zu erzielen, sollte die Möglichkeit, ein Empfehlungssystem auf Basis eines Data Warehouse zu betreiben, weiter erörtert werden.

Big Data oder Data Warehouse?

Diese Beispiele zeigen, dass große Datenmengen, Feinkörnigkeit sowie kurze Latenzzeiten für Big-Data-Verfahren sprechen. Andererseits lassen sich Anwendungen, die auf den ersten Blick Big Data vorbehalten sind, sehr wohl auch mit einem Data Warehouse erfüllen. Nachteile sind hier jedoch die eingeschränkte Datenmenge, die Grobkörnigkeit und die längere Latenzzeit. Auch die Komplexität der statistischen Verfahren, die den Kern der Anwendungen ausmachen, ist von entscheidender Bedeutung. So lassen sich Analysen mit Pivottabellen im Data Warehouse unkompliziert via Drag and Drop vornehmen. Statistische Vorkenntnisse sind in der Regel nicht erforderlich. Verfahren wie Mustererkennung, Segmentierung, Monitoring und Empfehlungssysteme setzen hingegen Statistikkenntnisse voraus.

Big Data oder DW: Acht Schritte bis zur Einführung

Die Entscheidung für Big Data oder ein Data Warehouse wird am besten im Rahmen einer schrittweisen Problemlösung getrofffen:

-

Identifikation des Problems, das mit Big Data oder einem Data Warehouse zu lösen ist.

-

Erarbeitung der statistischen Lösung.

-

Ermittlung der erforderlichen Daten: Menge, Körnigkeit und Latenz.

-

Entscheidung über die optimale technische Lösung: Big Data oder Data Warehouse.

-

Ermittlung des Nutzens.

-

Falls der Nutzen überzeugt: Betrieb eines Pilotprojekts.

-

Nach Erfolg des Pilotprojekts: Schulung in Statistikverfahren und Einführung der Lösung.

-

Laufende Beurteilung und Weiterentwicklung der Lösung.

IT-Entscheider müssen Aufwand und Nutzen beider Lösungen einander gegenüberstellen. Der Ertrag zeigt sich oft in Form von erhöhtem Umsatz, geringeren Betriebskosten oder gesteigerter Produkt- und Servicequalität. Doch die Kosten sollten keinesfalls außer Acht gelassen werden. Dazu zählen vor allem Investitionen für Hard- und Software, Schulungs- und Einarbeitungskosten sowie Einführungs- und Betriebsausgaben. Auch gilt es zu bedenken, dass Big-Data-Lösungen vielfach die Reifephase für den Markt noch nicht erreicht haben - technische Standards entstehen zum Teil erst.

Die Anwendung von statistischen Verfahren, bei Big Data wie bei Data Warehouses, setzt Fachwissen voraus. Das ist nicht in jedem Unternehmen vorhanden und muss Entwicklern, Sachbearbeitern und Managern oft erst vermittelt werden. Auch die Anwendung von Statistikverfahren ist in beiden Fällen anspruchsvoll. Daher sollte man diese Verfahren schrittweise einführen. Ein internes Kompetenzzentrum für die Anwendung statistischer Verfahren sollte die Projekte unterstützen.

Die technischen Einzelheiten von statistischen Verfahren wie zum Beispiel Empfehlungssystemen werden von Unternehmen oft geheim gehalten oder nur in groben Zügen nach außen kommuniziert. Newcomer müssen sich deshalb das Grundlagenwissen selbst aneignen und die Lösung bestehender Probleme angehen, ohne die praktischen Details bereits vorhandener Lösungen zu kennen.

Pilotprojekte helfen planen

Der finanzielle und zeitliche Aufwand für die Einführung der neuen Lösung darf nicht unterschätzt werden. Um den Aufwand zuverlässig planen zu können, sollten erste Erfahrungen in Pilotprojekten gesammelt werden. Deren Mitarbeiter sollten jeweils für relevante und klar abgesteckte Probleme zuständig sein.

Zu Beginn sollten zudem möglichst einfache statistische Verfahren zum Einsatz kommen, um damit das erforderliche Know-how allmählich aufzubauen. Aus den Pilotprojekten gewonnene Erkenntnisse helfen bei der schrittweisen Einführung. Anschließend gilt es, die eingeführte Lösung kontinuierlich zu beurteilen und weiterzuentwickeln. Quelle

Ilias Ortega

Mit Business Intelligence zu Access Intelligence

- Details

Mit Hilfe einer intelligenten Berechtigungs-verwaltung lässt sich das Identity Management effizienter machen, sagen Experten. Dafür sorgen sollen bewährte Werkzeuge aus der Business-Intelligence-Welt.

Mit Hilfe einer intelligenten Berechtigungs-verwaltung lässt sich das Identity Management effizienter machen, sagen Experten. Dafür sorgen sollen bewährte Werkzeuge aus der Business-Intelligence-Welt.

Im Berechtigungs-Management ist heute mehr Effizienz und Intelligenz gefordert. Immer zahlreichere gesetzliche Regeln, wie Informationen zu handhaben sind, sowie komplexe IT-Infrastrukturen rund um On-Premise- und Cloud-Systeme, in denen Datenflüsse intelligent gesteuert werden wollen, lassen herkömmliche Identity-Management-Konzepte (IdM) schnell an ihre Grenzen stoßen. Zudem gilt es, alle Beteiligten enger einzubinden, aber auch stärker in die Pflicht zu nehmen.

Eine Governance im Berechtigungs-Management - auch als Access Governance bezeichnet - bedeutet, dass die Fachabteilungen mehr Verantwortung übernehmen müssen. Dies erfordert wiederum mehr Kontrolle im Rahmen der Berechtigungsvergabe, aber auch die regelmäßige Bestätigung von bestehenden Berechtigungen. Eine besondere Herausforderung ist hierbei, die komplexen und umfangreichen Datenstrukturen so aufzubereiten, dass diese in verständlichen Informationen verdichtet und präsentiert werden können.

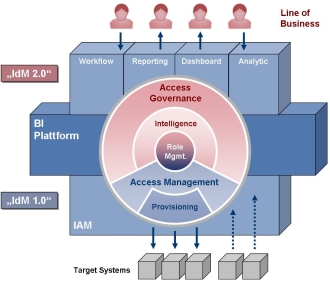

Um das zu erreichen, können Anwender auf etablierte Verfahren aus dem Bereich Business Intelligence zurückgreifen. Berechtigungsstrukturen mit Hilfe von BI-Methoden aufzubereiten, mündet letztendlich in Access Intelligence. Dafür werden die aus Business Intelligence (BI) erprobten Technologien und Vorgehensweisen für mehr Transparenz über die Berechtigungen genutzt. Bekannte Methoden werden mit neuen Anwendungsgebieten verknüpft.

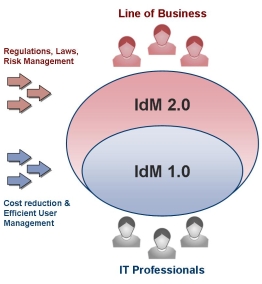

Identity Management wandelt sich

Experten sprechen heute bereits von Identity Managament 2.0 (IdM 2.0), da sich der Community-getriebene Ansatz des Web 2.0 Inhalte zu erzeugen, auch auf das IdM-Umfeld übertragen lässt. Identity Management der ersten Generation (IdM 1.0) war IT-lastig, Administrator-orientiert und stellte den Single-Point-of-Administration, das HR-driven Provisioning sowie Role Based Access Control (RBAC) in den Vordergrund.

Die IdM-2.0-Systeme fungieren dagegen als eine Art Business-Collaboration-Plattform für die Zugriffsverwaltung. Diese Systeme werden seitens der User anders wahrgenommen und genutzt, beziehen die Fachabteilungen in die Entscheidungsprozesse mit ein und sind mit Business-orientierten Funktionen sowie umfangreichen Self-Service-Möglichkeiten ausgestattet. Letztlich ist in einem solchen Umfeld der einzelne Anwender mehr denn je verantwortungsvoll in die sichere und regelkonforme Verwaltung der Zugriffsrechte mit einbezogen.

Die IdM-2.0-Systeme fungieren dagegen als eine Art Business-Collaboration-Plattform für die Zugriffsverwaltung. Diese Systeme werden seitens der User anders wahrgenommen und genutzt, beziehen die Fachabteilungen in die Entscheidungsprozesse mit ein und sind mit Business-orientierten Funktionen sowie umfangreichen Self-Service-Möglichkeiten ausgestattet. Letztlich ist in einem solchen Umfeld der einzelne Anwender mehr denn je verantwortungsvoll in die sichere und regelkonforme Verwaltung der Zugriffsrechte mit einbezogen.

Doch damit hat sich auch die Zielsetzung eines IdM-Systems gewandelt. Standen früher Faktoren wie Kostensenkung und effizientes User-Management im Vordergrund, suchen Unternehmen heute nach einem System, mit dem sie zusätzlich Regularien und Gesetze sowie das Risiko-Management bewältigen können. Die IdM-2.0-Systeme passen somit auch in den größeren Rahmen einer umfassenden Access Governance.

Aus Identity Management wird Access Governance

Der Wandel des IdM hin zur Access Governance führt zu neuen Aufgaben und Funktionen. Zu den wichtigsten Bausteinen zählen das Antrags- und Genehmigungsverfahren für neue Berechtigungen sowie die Auswertung und Zertifizierung von bestehenden Berechtigungen. Als Basis dafür dient eine Business-orientierte Modellierung der Rollen einschließlich einer Risikobewertung. Im Folgenden soll kurz auf die einzelnen Module von Access Governance eingegangen werden.

Anstatt den Benutzern einfach die Berechtigungen zuzuweisen, wird ein Antrags- und Genehmigungsverfahren für die Zuweisung von Rollen, Zugriffsrechten und dergleichen benötigt. Dieses muss durch einen automatisierten Workflow unterstützt sein. Verlangt wird außerdem eine bessere Transparenz bei den bestehenden Zugriffsrechten. Sie ist die Grundvoraussetzung für den Zertifizierungsvorgang, in dessen Rahmen der Vorgesetzte regelmäßig die Berechtigungen der Benutzer hinsichtlich ihrer Notwendigkeit überprüft und bestätigt. Dadurch lassen sich auch die Risiken hinsichtlich eines Anhäufens von Berechtigungen begrenzen. Die Messlatte dabei sollte das Prinzip des "Least Privileged" sein, also der Begrenzung der Rechte auf das notwendige Minimum.

Anstatt den Benutzern einfach die Berechtigungen zuzuweisen, wird ein Antrags- und Genehmigungsverfahren für die Zuweisung von Rollen, Zugriffsrechten und dergleichen benötigt. Dieses muss durch einen automatisierten Workflow unterstützt sein. Verlangt wird außerdem eine bessere Transparenz bei den bestehenden Zugriffsrechten. Sie ist die Grundvoraussetzung für den Zertifizierungsvorgang, in dessen Rahmen der Vorgesetzte regelmäßig die Berechtigungen der Benutzer hinsichtlich ihrer Notwendigkeit überprüft und bestätigt. Dadurch lassen sich auch die Risiken hinsichtlich eines Anhäufens von Berechtigungen begrenzen. Die Messlatte dabei sollte das Prinzip des "Least Privileged" sein, also der Begrenzung der Rechte auf das notwendige Minimum.

Die Business-orientierte Modellierung von Rollen beinhaltet das Erstellen von Rollen, die für die Fachabteilung verständlich sein sollten. Das ist die Voraussetzung für das Antrags- und Genehmigungsverfahren, sowie für die Zertifizierungen. Die Fachabteilungen können nur dann Rollen beantragen, genehmigen oder zertifizieren, wenn sie diese kennen und verstehen. Neben der ursprünglichen Aufgabe der Berechtigungskapselung müssen die Rollen daher jetzt auch aus der Sicht der Genehmigungs- und Zertifizierungsfähigkeiten erstellt werden.

Es gibt verschiedene Richtlinien, die bei der Berechtigungsvergabe berücksichtigt werden müssen. Die wichtigste und bekannteste ist die Trennung der Funktionen (Segregation-of-Duty - SoD). Hier gilt es bestimmte Kombinationen von Berechtigungen zu vermeiden, die auch als toxische Kombinationen bezeichnet werden. Im Rahmen von Access Governance müssen die Verantwortlichen die darunterliegenden SoD-Regeln definieren und bei der Berechtigungsvergabe berücksichtigen. Darüber hinaus müssen sich auch die bestehenden Berechtigungen nachträglich kontrollieren lassen.

Bei der Betrachtung von Berechtigungen dürfen die Unternehmen die historische Dimension nicht vernachlässigen. So reicht es nicht aus, nur die aktuellen Berechtigungen auswerten zu können. Vielmehr müssen sich diese auch in der Zeitachse darstellen lassen. Eine Grundfrage dabei ist: Welche Rechte hatte ein Benutzer in der Vergangenheit? Ferner gilt es zu prüfen, wer diese Rechte beantragt, genehmigt und zertifiziert hat. Dies hilft beispielsweise dabei, Unregelmäßigkeiten in betrieblichen Abläufen nachträglich untersuchen zu können.

Durch das User Activity Monitoring lassen sich die Benutzeraktivitäten zu den Berechtigungsstrukturen in Beziehung setzen. Dazu werden die Informationen in den Protokolldateien der Systeme herangezogen, um zum Beispiel Aussagen treffen zu können, wie oft und wann Berechtigungen von den Benutzern überhaupt verwendet werden. Auf Basis dieser Informationen lassen sich die Berechtigungsstrukturen passgenauer an die betrieblichen Anforderungen anpassen.

Access Governance braucht Verfahren für die Fachabteilung

Die zusätzlichen Anforderungen im Rahmen von Access Governance müssen Unternehmen durch neue Verfahren in der Berechtigungsverwaltung abgebilden. Das klassische IdM-System benötigt in diesem Zusammenhang eine fachabteilungstaugliche Komponente, die den Mitarbeitern dort eine am Geschäftsprozess ausgerichtete Sicht auf Identitäten und deren Rechte vermittelt.

Dazu müssen die bestehenden IdM-Systeme um Business-orientierte Aspekte erweitert werden. Dies kann beispielsweise durch eine weitere Schicht im IdM-System erfolgen. Eingeschlossen sein sollten außerdem Funktionen für die Analyse der Zugriffsrechte, Reporting-Funktionen sowie die regelmäßige Überwachung der Zugriffe durch Prüfroutinen. Um den Zugang für die Mitarbeiter der Fachbereiche zu vereinfachen, bietet sich ferner ein Webportal an.

Die Herausforderung liegt in der Datenmenge

Die feingranulare Aufschlüsselung der Rechte und deren detaillierte Überwachung, die auch die Historie betrachten sollte, führt jedoch zu einer besonderen Herausforderung: Die Menge der Daten wächst kontinuierlich an. So umfassen große IdM-Lösungen beispielsweise im Bankenbereich bis zu 100.000 Benutzer mit zusammen 500.000 Accounts und 35.000 Rollen sowie 700.000 Berechtigungsgruppen aus einer Vielzahl von Anwendungen. Dazu kommt, dass diese Daten keine statischen Strukturen aufweisen. Das zeigen die Änderungsprotokolle der Systeme. Diese weisen zum Teil mehr als 250 Millionen Einträge pro Jahr auf.

Damit entsteht eine unglaubliche Datenfülle, die es zu handhaben gilt. Hinzu kommt außerdem, dass die Berechtigungen und damit die generierte Datenbasis permanenten Veränderungen unterworfen sind. Änderungen innerhalb der Organisation, neue Anwendungen und modifizierte Richtlinien erweitern beständig die Datenbasis. Diese manuell auszuwerten, ist fast unmöglich. Nur durch den Einsatz von Automatismen lässt sich letztendlich die durch das IdM verursachte Datenfülle bewältigen.

Business Intelligence für das Berechtigungsmanagement

Anstelle der sonst typischen Frage "Make or Buy" stellt sich an dieser Stelle für die Unternehmen die Frage nach dem "Make-self or Reuse". Die IT bietet bereits heute viele wieder verwendbare Techniken, um große Datenmengen schnell und effizient zu bearbeiten. Die eigenständige Entwicklung von Softwaresystemen ist dagegen teuer und aufwändig. Dies gilt insbesondere für den Bereich Business Intelligence (BI). Zu dessen Kernfunktionen gehört es, Daten durch ETL-Tools aufzubereiten, die Informationen in einem Data Warehouse zu speichern und in der Folge zu analysieren sowie die Ergebnisse mit ansprechenden Auswertungen in Form von Grafiken, Pivot-Tabellen oder KPIs zu präsentieren.

Anstelle der sonst typischen Frage "Make or Buy" stellt sich an dieser Stelle für die Unternehmen die Frage nach dem "Make-self or Reuse". Die IT bietet bereits heute viele wieder verwendbare Techniken, um große Datenmengen schnell und effizient zu bearbeiten. Die eigenständige Entwicklung von Softwaresystemen ist dagegen teuer und aufwändig. Dies gilt insbesondere für den Bereich Business Intelligence (BI). Zu dessen Kernfunktionen gehört es, Daten durch ETL-Tools aufzubereiten, die Informationen in einem Data Warehouse zu speichern und in der Folge zu analysieren sowie die Ergebnisse mit ansprechenden Auswertungen in Form von Grafiken, Pivot-Tabellen oder KPIs zu präsentieren.

Warum sollten diese Techniken nicht auch für die Analyse von Berechtigungen herangezogen werden? Statt Umsatz- oder Marktzahlen werden nun eben Berechtigungsstrukturen analysiert. Für die in den BI-Tools integrierten Methoden und Verfahren macht das keinen Unterschied. Unter dem Einfluss der BI-Werkzeuge entwickelt sich die Access Governance zur Access Intelligence. Dabei werden die technischen Hilfsmittel und Möglichkeiten aus dem Bereich BI mit der Datenbasis der Access Governance verknüpft. Für die Access Governance eröffnet das völlig neue und vor allem sofort nutzbare Möglichkeiten zur Analyse und Aufbereitung der Datenbasis der Berechtigungssysteme.

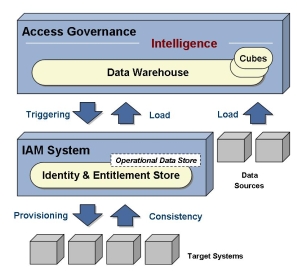

Trennung in operative und analytische Daten

Von Vorteil ist dabei die Trennung der Datenbasis in einen Anteil für operative Systeme und einen zweiten für die Datenanalyse. Diese Trennung findet sich heute in nahezu allen gängigen BI-Lösungen und hat sich bewährt, da auf diese Weise für eine gesicherte Basis gesorgt wird. Zudem bringen operative und analytische Daten hinsichtlich der Datenaufbereitung unterschiedliche Anforderungen mit sich. Während operative Datenbanken (auch Operational Data Store genannt) normalisierte Datenmodelle benötigen, um die Update-Operationen schnell bedienen zu können, sind analytische Daten redundant organisiert. Sie sind auf schnelle Lese-Operationen von komplexen Strukturen ausgelegt.

Zusätzlich lassen sich durch die Aufteilung die Systeme für das Reporting von den operativen Systemen entkoppeln. Das sorgt für eine bessere Skalierbarkeit und Performance. Ebenso können Anwender auf diesem Weg Sicherheitsaspekte leichter umsetzen.

Eigenentwicklung oder offene Plattform

Bei der Auswahl der BI-Plattform stellt sich den Anwenderunternehmen die Frage, selbst eine eigenständige Lösung zu entwickeln oder auf eine offene BI-Infrastruktur auf dem Markt zurückzugreifen. Hier zeigt sich, dass eigenständige Implementierungen meist mit mehr Nachteilen als Vorteilen einhergehen. Diese führen oft zu Silo-Anwendungen. Ferner sind Erweiterungs- und Skalierbarkeitsmöglichkeiten meist begrenzt.

Vieles spricht daher für die Nutzung einer offenen Plattform. Dabei kümmert sich bereits der Anbieter der BI-Tools um genügend Leistung und die Skalierbarkeit der Systeme. Des weiteren sind diese Systeme in der Regel offen für kundenspezifische Erweiterungen. Durch den Ausbau mit weiteren Lösungspaketen entsteht dabei eine unternehmensweite Informationsplattform.

Beta System beispielsweise kooperiert in dieser Hinsicht mit Microsoft und nutzt deren BI-Suite basierend auf dem SQL Server. Durch die Nutzung der vorhandenen BI-Tools lassen sich die Benutzerdaten, deren Rollen und Berechtigungen in ein völlig neues Licht rücken. Dies lässt sich an einem einfachen Datenmodell verdeutlichen:

Die Datenaufbereitung in einem Data Warehouse erfolgt primär nach dem Star-Schema. Dabei werden Daten und Metadaten sternförmig angeordnet. Im Mittelpunkt stehen die eigentlichen Fakten zum Beispiel die Gruppenzuweisungen eines Benutzers. Der Benutzer und seine Berechtigungspfade sind an diese Gruppenzuweisung gekoppelt. Weiter außen hängen weitere Attribute wie etwa die Funktion des Benutzers oder seine Lokation (der Beschäftigungsort). Auf Basis dieses sternförmigen Datenmodells lassen sich die Berechtigungsstrukturen so abbilden, dass diese nach verschiedensten Kriterien effizient analysiert werden können.

Das Datenmodell dient nicht nur für die effiziente Auswertung, sondern stellt mit seinen Business-verständlichen Metainformationen auch eine Art "Business Access Semantik Modell" dar. Unterstützt durch die bestehenden Werkzeuge lassen sich Analysen und Auswertungen beschleunigen und vereinfachen. Dabei helfen auch die modernen Bedienlogiken in Windows mit Drag-and-Drop, Drilldown und einem breiten Set an Visualisierungsmöglichkeiten.

Bessere Analysen und Auswertungen

Die bestehenden Analysetools geben Antworten auf typische Fragen in der Berechtigungsverwaltung wie etwa: "Wer hat aktuell welche Berechtigung?" oder "Wie waren dessen Rechte in der Vergangenheit?". Ferner lassen sich darüber hinaus auch weitergehende Analysen nach dem Risiko und der Zertifizierungsvorgänge leichter gewinnen.

Beispielsweise erhalten Anwender Kennzahlen (KPI) über verschiedene Kriterien der Berechtigungsverwaltung. Dies gilt sowohl für die Analysen von Einzelobjekten wie etwa den Anwendern oder Rollen, aber auch den Beziehungen zwischen diesen Objekten. Des weiteren lassen sich Schwellwerte überwachen. Benutzer, die beispielsweise ein erhöhtes Risiko aufweisen, lassen sich sehr einfach auffinden. Und schließlich liefern die vorbereiteten BI-Werkzeuge einen Fundus an Analysen zum Trendverhalten, der Mustererkennung oder anderen komplexeren Auswertungen.

Fazit

Das Thema Access-Governance und -Intelligence wird an Bedeutung gewinnen und wesentlich die weitere strategische Ausrichtung im Bereich IdM beeinflussen. Entsprechende Lösungen bieten ein Workflow-basiertes Antrags- und Genehmigungsverfahren, sowie zukünftig eine Business-Intelligence-Infrastruktur für Business-orientierte Auswertungen in Form von Analysen, Reports und Dashboards. Dies alles sorgt für mehr Kontrolle und Transparenz. Die Anbieter bauen dabei auf ihre Kompetenzen beim automatisierten Provisioning (Verteilen von Berechtigungen) und eine breite Unterstützung von Zielsystemen durch Standard-Konnektoren. Durch die Nutzung von bestehenden BI-Systemen lassen sich so die Möglichkeiten des Berechtigungs-Management hin zur Access Intelligence erweitern. Quelle

Detlef Sturm

IT-Abteilungen gewichten technische Trends

- Details

Exklusive Anwenderstudie für Deutschland: Gut, wenn der CFO weiß, wo das eigene IT-Management derzeit die größten Aufgaben im täglichen Support sieht. Die Anwenderstudie "IT-Kompass 2012" stellt die Themen vor.

Exklusive Anwenderstudie für Deutschland: Gut, wenn der CFO weiß, wo das eigene IT-Management derzeit die größten Aufgaben im täglichen Support sieht. Die Anwenderstudie "IT-Kompass 2012" stellt die Themen vor.

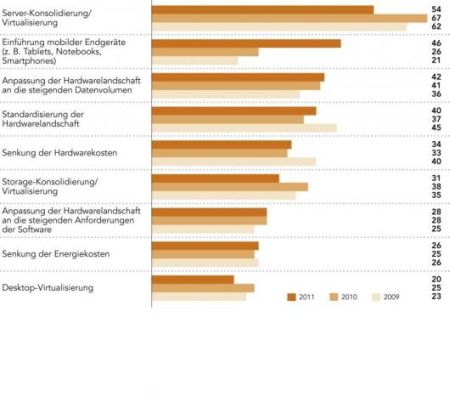

Fragt man derzeit, welche IT-Themen auf der Agenda deutscher Unternehmen stehen, so ergibt sich ein buntes Bild. So zeigt sich generell im Vergleich zur Vorjahresstudie der CFOworld-Schwesterpublikation "Computerwoche" und den Marktforschern von IDC, dass das Thema Server-Konsolidierung und -Virtualisierung für IT-Entscheidern an Bedeutung verloren - ein Beleg für die vielerorts abgeschlossenen Bemühungen, die IT-Infrastruktur effizienter aufzustellen. Ähnliches gilt für die Storage-Systeme im IT-Backend.

Mobile Endgeräte

Deutlich mehr Arbeit befürchten IT-Verantwortliche dagegen beim Verwalten mobiler Endgeräte. Im Vergleich zum Vorjahr halten fast doppelt so viele Befragte einschlägige Projekte mit Tablets, Smartphones und Notebooks für ein wichtiges Thema (siehe auch den Beitrag zum Slogan "Bring your own device").

"Zum ersten Mal steht in diesem Jahr die Einführung mobiler Endgeräte auf Platz zwei der wichtigsten Hardwarethemen", kommentiert IDC-Analystin Jennifer Waldeck. Wegen der aktuell unsicheren wirtschaftlichen Situation sei zwar auch das Thema Kostensenken für die IT-Profis wieder etwas wichtiger geworden. Doch die hohe Bedeutung aus dem Jahr 2009, als 40 Prozent der Befragten die Hardwarekosten als kritisch erachteten, wird nicht mehr erreicht.

Desktop-Virtualisierung

Etwas überraschend erscheint in diesem Kontext, dass Desktop-Virtualisierung für die Unternehmen offenbar in Relation zu anderen Themen an Attraktivität verloren hat. Immerhin versprechen die IT-Anbieter in diesem Marktsegment erhebliche Kosteneffekte, wenn Desktop-Umgebungen in virtueller Form auf zentralen Servern vorgehalten und gepflegt werden.

Die derzeit wichtigsten Hardware-Themen in deutsche IT-Abteilungen.

Die derzeit wichtigsten Hardware-Themen in deutsche IT-Abteilungen.

Matthias Kraus, Research Analyst bei IDC, interpretiert diesen Befund so: "Einige Unternehmen haben bereits im vergangenen Jahr Desktop-Virtualisierung umgesetzt". Zudem versprächen Investitionen in Desktop-Virtualisierung eher mittelfristig Einsparungen. Angesichts der aktuell abgekühlten wirtschaftlichen Rahmenbedingungen konzentrierten sich Unternehmen aber wieder etwas mehr auf Maßnahmen, die einen kurzfristiger Return-on-Investment (ROI) versprechen.

Zufriedenheit mit IT-Lieferanten

Geht es um die Zufriedenheit mit den IT-Lieferanten, machen die Hardwareanbieter erneut Boden gut. Insbesondere mit den Preisen, aber auch mit der Qualität der Produkte zeigen sich die Befragten im Vergleich zum Vorjahr zufriedener. Der anhaltende Wettbewerbsdruck in der Branche dürfte dazu beigetragen haben. IDC beobachtet schon seit einigen Jahren, dass sich die Produktqualität der Hersteller in vielen Hardwarebereichen angleicht.

Softwarethemen in deutschen IT-Abteilungen

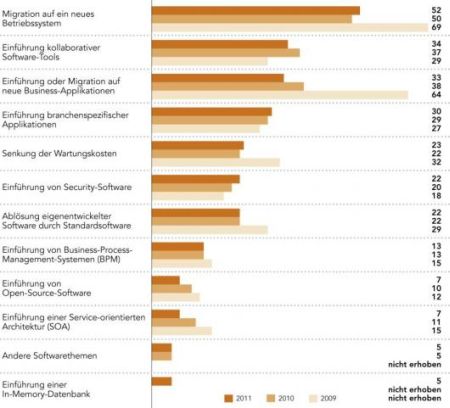

Die Migration auf ein neues Betriebssystem steht ganz oben im Ranking der wichtigsten Softwarethemen. Noch immer beschäftigten sich etliche Unternehmen mit einer Ablösung von Windows XP, erklärt IDC-Experte Matthias Zacher dazu. Aber auch die Einführung kollaborativer Software-Tools und neue Business-Applikationen haben weiterhin eine hohe Bedeutung, auch wenn letzteres Thema im Vergleich zum Vorjahr einige Prozentpunkte verloren hat.

Reizthema Security

Zugelegt hat dagegen der Dauerbrenner Sicherheit. Nach Prognosen von IDC wird Security-Software in Deutschland deutlich über dem Marktdurchschnitt wachsen. Ähnliches gelte für die Segmente Business Analytics, CRM, Human Capital Management (HCM) und kollaborative Anwendungen. Das für den IT-Kompass 2012 erstmals abgefragte Thema "In Memory-Datenbanken" halten derzeit lediglich fünf Prozent der IT-Entscheider für wichtig.

Cloud, Mobility, Big Data

Dessen ungeachtet gehen IDC-Experten davon aus, dass Cloud-Services, Mobility und Big Data die Neu- und Weiterentwicklung von Anwendungen wesentlich beeinflussen werden. "Cloud-Services und -Plattformen spielen eine zentrale Rolle für das Entwickeln und Verteilen neuer Anwendungen", erläutert Zacher. "Anwender erwarten, dass Geschäftsprozesse auch mit mobilen Lösungen und Anwendungsszenarien unterstützt werden."

Die derzeit wichtigsten Software-Themen in deutsche IT-Abteilungen

Die derzeit wichtigsten Software-Themen in deutsche IT-AbteilungenZufriedenheit mit Software-Lieferanten

Auch mit ihren Softwarelieferanten sind die Interviewten zufriedener als im Vorjahr. Im Vergleich zu den Hardware- und Serviceanbietern schneiden diese aber noch immer schlechter ab, was zum Großteil auf die Lizenz- und Preispolitik zurückzuführen ist. Hier sollten die Hersteller nachbessern, fordert Zacher: "Anwender benötigen (…) transparente, verlässliche und auf ihre Belange zugeschnittene Lizenzmodelle. Das gilt sowohl für On-Premise als auch für Software as a Service." Insbesondere nutzungsabhängige Bezahlmodelle könnten mehr Klarheit bringen.

IT-Services in deutschen IT-Abteilungen

Betrachtet man die wichtigsten IT-Servicethemen, ergibt sich ein klares Bild. Höhere Service-Levels der internen IT sowie Helpdesk- und Support-Funktionen haben für die Befragten weiter Priorität (siehe Grafik: Die wichtigsten Servicethemen). Allerdings wurden diese Aufgaben im Vergleich zum Vorjahr deutlich seltener genannt.

Service-Level-Agreements

Die Veränderung zeige, dass sich die IT-Abteilungen auf einem guten Weg befänden und die Erfüllung der SLAs (Service Level Agreements) immer besser und zuverlässiger im Griff hätten, kommentiert IDC-Analyst Kraus: "Der operative Betrieb wird mit Hilfe von professionellen IT-Industrialisierungsmethoden wie zum Beispiel ITIL, Tools zur automatisierten Steuerung der IT-Services und besser ausgebildeten IT-Fachkräften gewährleistet."

Status Cloud Computing

Einen Sprung nach vorne macht das längst nicht mehr neue Thema Cloud Computing. Fast jedes fünfte Unternehmen zählt die Wolken-IT inzwischen zu den wichtigsten Servicethemen, eine Steigerung um 5 Prozentpunkte gegenüber dem Vorjahr. Kraus erklärt den Zuwachs vor allem mit den konjunkturellen Rahmenbedingungen (Lesen Sie auch unseren Ratgeber zu Cloud Computing und den Risiken).

"Cloud Computing bietet den Nutzen, IT viel günstiger und flexibler zu beziehen." Damit könne sie nicht nur wesentlich schneller neue Anforderungen der Geschäftsbereiche umsetzen, sondern sich auch einem veränderten Bedarf agil anpassen: "Cloud Computing ist (..) in den derzeit wirtschaftlich unsicheren Zeiten ein ideales Instrument, um den viel zu hohen IT-Fixkostenblock zu senken und auf konjunkturelle Veränderungen kurzfristig reagieren zu können."

IT-Weiterbildung und Schulungen

Eine wichtigere Rolle als im Vorjahr spielt für IT-Verantwortliche auch das Thema Weiterbildung und Schulung. Angesichts des Fachkräftemangels und des tiefgreifenden technologischen Wandels sei die permanente Schulung und Qualifizierung wichtig, um die Qualität der IT-Services zu garantieren und Mitarbeiter an das eigene Unternehmen zu binden, erläutern die IDC-Experten.

IT-Outsourcing und Service-Provider

Ein bedeutendes Servicethema für die Befragten bleibt generell die Auslagerung von IT-Ressourcen. Betrachtet man die geplanten Outsourcing-Vorhaben genauer, steht die IT-Infrastruktur (Server, Data Center) erneut an erster Stelle. Im Jahresvergleich hat das Thema etwas an Bedeutung verloren.

mmer mehr Unternehmen setzten im abgelaufenen Jahr auf die Auslagerung ihrer Rechenzentren, Server oder Desktop-Arbeitsplätze, um Mitarbeiter von operativen Tätigkeiten zu entlasten, erklärt Kraus die Entwicklung. Es sei keine Überraschung, dass die Zahlen jetzt wieder leicht zurückgehen.

Application-Hosting

Neben der Infrastruktur planen deutsche Unternehmen auch, ihre Applikationen im Rechenzentrum eines Service-Providers betreiben zu lassen. IDC betrachtet Application Hosting auch als Vorstufe des Cloud Computings. Die Offenheit der Unternehmen gegenüber Hosting-Modellen untermauert aus Sicht der Analysten den Trend zur Wolken-IT.

In Sachen Kundenzufriedenheit haben die IT-Serviceanbieter einen Sprung nach vorne gemacht. (siehe Grafik: Zufriedenheit mit Serviceanbietern). Von den Anwenderunternehmen werden sie nun fast ebenso gut bewertet wie die Hardwarelieferanten. Auffällig ist, dass die Umfrageteilnehmer vor allem mit dem Prozess-Know-how der Dienstleister zufriedener sind. Zudem sind die Service-Provider inzwischen offenbar deutlich flexibler, wenn es um Änderungswünsche der Kunden während der Vertragslaufzeit geht.

IT-Services als Angebote

"Die gesteigerte Flexibilität (…) wird auch durch die zunehmend standardisierten und modularen Angebote der Dienstleister ermöglicht", erklärt Kraus. Hierzu zählten insbesondere Cloud-Services-Angebote in all ihren Facetten. IDC beobachte, dass Cloud-Services bei der Verlängerung oder dem Neuabschluss von Outsourcing-Verträgen immer häufiger fester Bestandteil seien.

Fachkräftemangel in der IT

Ein drängendes Problem deutscher Unternehmen bleibt der Mangel an IT-Fachkräften. 71 Prozent der Befragten melden akuten Bedarf an qualifiziertem Personal. Vor allem an Support-Mitarbeitern fehlt es, die Nachfrage hat im Vergleich zum Vorjahr stark zugenommen (siehe Grafik: Bedarf an IT-Fachkräften). Auf der Wunschliste der IT-Chefs stehen auch weiterhin Spezialisten für Business Applications wie ERP oder BI (Business Intelligence), wenn auch nicht mehr in dem Maße wie in den vorangegangen zwei Jahren. (Viele Informationen zu Trends und dem Management von Business Intelligence finden Sie auch hier auf CFOworld).

Immerhin sieben Prozent der Umfrageteilnehmer suchen explizit nach Experten für Cloud Computing. Daraus zu schließen, die Zeiten der Großrechner-IT im RZ neigten sich dem Ende zu, wäre allerdings verfehlt. Der Bedarf an Mainframe-Spezialisten ist in den letzten drei Jahren relativ konstant geblieben und zuletzt sogar wieder leicht gestiegen.

Mit freundlicher Genehmigung der CFoworld-Schwesterpublikation Computerwoche.

Wolfgang Herrmann

PowerPoint statt klares Denken

- Details

PowerPoint ist nützlich. Referenten lieben es. Doch Zuhörer sind schnell durch peinliche Dekorationen und eine unklare Argumentation gelangweilt. Das lässt sich verhindern.

PowerPoint ist nützlich. Referenten lieben es. Doch Zuhörer sind schnell durch peinliche Dekorationen und eine unklare Argumentation gelangweilt. Das lässt sich verhindern.

PowerPoint ist ein leistungsfähiges und für viele Zwecke sinnvoll einsetzbares Software-Produkt. Man kann Fotos an die Wand projizieren, Filme integrieren und komplexe Tatbestände schrittweise aufbauen. Mit diesem Produkt geht aber eine ganz besondere "Kultur" einher, die klares Denken verhindert.

Bilder, Bulletpoints, Blabla

Diese Kultur ist durch eine mehr oder weniger synchron zum Vortrag verlaufende Verwendung von Textschaubildern, nichtssagende Auflistungen (Bullets) und mehr vom "schönen" Design als vom Inhalt geprägten Konzeptschaubildern gekennzeichnet. "Corporate Design" und "Folienvorlagen" stehen im Mittelpunkt, Logos und nichtsagende Rahmen sowie unnötige Hintergründe dominieren den visuellen Eindruck.

Die zu vermittelnde Botschaft wird nicht klar gesagt und Zuhörer verstehen die gedanklichen Zusammenhänge nicht. Warum das so ist und wie es besser geht, zeigen die folgenden drei Warnungen (mehr Tipps zur Gestaltung von Vorträgen finden Sie hier).

Erster Fehler mit PowerPoint: Keine Botschaft

Fehlerquelle Nummer eins sind fehlende oder unklare Botschaften. Eine Botschaft kann eine Feststellung sein, vielleicht auch eine Erklärung – am besten aber eine Empfehlung, die der Referent zu Beginn der Präsentation klar und deutlich nennt. Es ist ratsam, die Botschaft zuvor schriftlich zu fixieren, um sich selbst Klarheit über die dann folgende Argumentationskette zu verschaffen.

Zuhörer einbinden

„Nun will ich Ihnen mal unser Produkt vorstellen“ ist in diesem Sinne eine wenig interessante Botschaft, und die Zuhörer werden am Ende nicht wissen, ob sie nun alles gesehen haben. Besser ist es, wenn Sie Zuhörer mit der Botschaft „Unser Produkt senkt Ihre Druckkosten um mindestens 1.000 Euro pro Monat“ ansprechen. Das ist eine für das Publikum relevante Aussage, die sie auf ihren Wahrheitsgehalt überprüfen können (mehr Tipps zur Vorbereitung von Meetings finden Sie hier).

Zweiter Fehler mit PowerPoint: Falsche Schaubilder

Jedes Schaubild sollte nur einen Zweck verfolgen: Inhalte vermitteln, die mit Worten nicht oder nicht deutlich genug vermittelt werden können. Aus diesem Grund sollten Sie Textschaubilder prinzipiell vermeiden, und die beliebten "Bulletlisten" ebenfalls.

Zwar kann man sich das Gesehene und das Gehörte besser merken – aber nicht das GELESENE und das Gehörte! Ausnahmen: Der Referent redet ÜBER einen Text wie beispielsweise ein neues Gesetz, oder Vortragende und Zuhörende sprechen nicht, oder nicht gut genug, die gleiche Sprache.

Gute Schaubilder

Gute Schaubilder zeichnen sich dadurch aus, dass eine Botschaft vermittelt wird, ohne banal zu sein. Die Aussage "Unser Projekt hat vier Phasen" ist banal. Dagegen könnte folgende Aussage das Publikum interessieren: "Wenn wir nicht in Phase 2 dies tun, dann könnte folgendes passieren…" Gute Schaubilder heben zudem die Botschaft in geeigneter Form hervor, sei es durch Einkreisen, Unterstreichen, Pfeile oder andere Hilfsmittel.

Dritter Fehler mit PowerPoint: Zu viel Dekoration

Rahmen, Ränder, Schatten, Hintergründe und Farben ohne Bedeutung, übergroße Firmenlogos und die nicht vermeidbaren Corporate-Design-Vorgaben: In der Regel haben PowerPoint-Folien eine etwas zu bunte, laute und aufwändige Dekoration.

Relevant statt hübsch

Sie sollten prinzipiell auf alles verzichten, was keine Bedeutung hat und lediglich der Vorstellung eines "gefälligen Aussehens" dient. So ist es wenig hilfreich, wenn die Farbe Rot einerseits für Corporate Design und bedeutungsloses Design eingesetzt wird, andererseits aber für Hervorhebungen wie Ampeln und besondere Abweichungen.

Insbesondere Farben und Formen sind gut für die Vermittlung und Hervorhebung von komplexen Tatbeständen geeignet – es ist ungeschickt, wenn Farben und Formen allein der Dekoration geopfert werden.

Rolf Hichert